【编者按】

近日,中国科学技术大学科技商学院讲席教授、美国国家工程院院士张捷出席2024亚布力中国企业家论坛第十届创新年会并发表开幕演讲。

在演讲中,张捷院士围绕“非语音智能听觉”的基础科学问题及其产业化问题展开了深入分析解读。在张捷看来,做听觉的目的不是要取代视觉,而是希望大模型能像人一样,同时具备“视”与“听”,为更多领域创造更多价值。

张捷表示,在机器视觉领域,国内外的独角兽企业和上市公司很多,赛道拥挤;而在非语音智能听觉领域,一切才刚刚起步。

张捷认为,“非语音智能听觉”正成为一个全新的产业化赛道,其应用场景已遍布交通、安防、新能源等各个领域,在国内可应用于多个万亿市场。

本文主体内容根据张捷院士亚布力论坛演讲实录删节整理,“科技商业观察”专栏第4期全文刊登发布。

中国有句古话叫“眼观六路,耳听八方”,说的就是人类的感知能力,而智能的感知就应该包括智能视觉与智能听觉。

此前的人工智能只有“眼睛”和语音对话,却没有能听环境的“耳朵”,感知系统并不完善。

举个例子,现在的机器人在声音感知上,主要依赖与人对话的“语音”进行辨识,但你要是给它鼓个掌,它就听不懂了。

非语音智能听觉刚刚起步

在视觉领域,国内外的独角兽企业和上市公司很多,赛道拥挤;而在非语音智能听觉领域,一切才刚刚起步。

非语音智能听觉基于物理学和大数据,模仿人类用耳朵去“听”。我们希望它在1-2秒内就能迅速做出反应,否则就称不上“智能”。

除了能监测到城市活动、交通活动、爆炸声等声音,智能听觉还能感知到人的耳朵听不见的声波和弹性波。比如,在脚上安装上感应器,机器人就能快速感知到一公里以外发生的车祸。所谓人工智能的“听觉”,就是基于声音和振动信号,弥补机器人缺失的感知能力。

非语音智能听觉主要是建立基于物理学的多模态大模型,我们不仅要知道声源在哪里,还要知道其他的物理属性,进而掌握更多的声源特征。对于真实场景下空气里传播的声音数据、地下的振动数据、视频数据等,我们设计模型,训练学习它们之间的关系。

一个事件的多种数据,可以采用传统的人工智能信号处理方法做预处理,但进一步的事件检测以及各种特性分析就涉及到物理学知识。这是非语音智能大模型的不同之处,它同时基于大数据和物理学。

比如,一个人转过头,看到背后有个小孩在跑。经过训练以后,我们掌握了小孩跑的场景与其声音振动的关系,然后背对着小孩,从声音震动也能够预测出跑动小孩的位置与速度等物理参数。

这个大模型不仅能输出很多参数,知道信号源的位置,当它在移动时,它的移动速度、形状、大小、尺寸及信号源和传感器之间的介质可能也在变化,而这些变化,新的大模型都能感应出来。

基于物理学和数据的大模型,凭借声音和振动,能让人即便闭上眼睛,也能听出背后的世界在干什么。这也是我们现在的机器人要补足的东西。我们做听觉的目的不是要取代视觉,而是希望大模型能像人一样,同时具备“视”与“听”,为更多领域创造更多价值。

基于物理学的大模型

非语音智能听觉应用场景广阔

以真实的交通场景录像为例。汽车在行走,我们一边录着像,同时在路边放着地震仪和声音监测设备。监测到声音的信号,以及波在地下传播的信号,大模型就开始学习它们之间的关系。掌握了这些关系以后,即便没有录像,也可以听出路面上的车型大小、车的行驶车道、行驶速度甚至车重,就连路面下的裂缝与结构变化也能听得出来。

20HZ-2000HZ是可听见的声波,听不见的次声波含有更多的信息,而且衰减非常慢,所以传播得非常远,几公里外都可以听到。声波是在空气和液体里传播的波,弹性波是在实体里传播的波,非语音听觉感知的范围就是在记录声波和弹性波。弹性波在地下的介质里也会传播得非常快,而且衰减慢,这样一来,它就有大量源的信息。

简单来说,当一个设备可以接收声波和弹性波的信号,将两者结合起来,它就会很有特点。比如,说话的声音在20米以外,就衰减没了;而跑步的振动,在一百多米甚至到两百米都可能监测到地动。

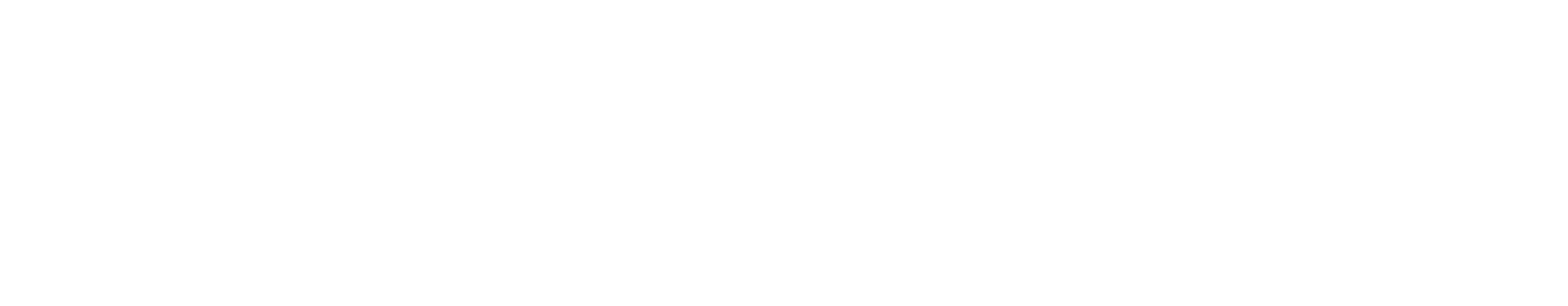

科学的基础涉及到地震学,地震学有140年历史。如果空气中有一个源产生振动,在空气里接收的是声波,到地下就变成地震波。

地震波是由地震震源向四处传播的振动,指从震源产生向四周辐射的弹性波。按传播方式可分为纵波(P波)、横波(S波)(纵波和横波均属于体波)和面波(L波)三种类型。P波就是振动的方向和传播的方向一致;S波就是振动方向和传播方向垂直往前走;面波沿着地表振动,它还包括勒夫波、瑞利波等。

这些波完全可以被记录到,我们再对它们进行分解,就可以推断波源、车型大小、行驶情况等多个物理信息。

过去地震仪研究的是3-8级地震,因为这是人体可感知的。近些年,为了预测地震,大家开始研究0-3级地震。由于石油产业是用地震的方法找石油(已有70多年历史),石油勘探工业又把震级的下限推到了-5级。

-3级地震,类似于桌上的茶杯掉到大理石的地上摔碎了,在200米外,能接收到它的声音和振动信号。

-5级地震,类似于将一根铅笔掰断,产生的声音和振动在200米外也能监测到。

工业上的页岩气在-2级到-5级的范围内,可以监测注水压力、找到石油,这在工业应用上已经非常成熟。

但在-5级到-1级这一领域,振动量的级别非常多,包括汽车、飞机等各种生活场景。如果能够完成对该领域关于“振动”的解析,那么它的应用范围就会更广。过去这一想法不太可能实现,但现在随着人工智能的出现,大模型可以对声音进行全自动的解析。

说到关键性的科学技术问题,这些年我们团队一直在解决“声音”和“振动”的问题。比如,去噪、事件检测、相位拾取等,利用地动仪记录声音(压力波)和振动(弹性波)信号,并通过5G实时传输,再应用人工智能实时处理与解释数据。

欧洲在疫情期间,就通过地动仪来监测疫情期间的封城情况、城市的活动情况等。最近,欧洲的足球赛也是用地动仪来监测观众在场馆里的振动情况,避免共振情况。

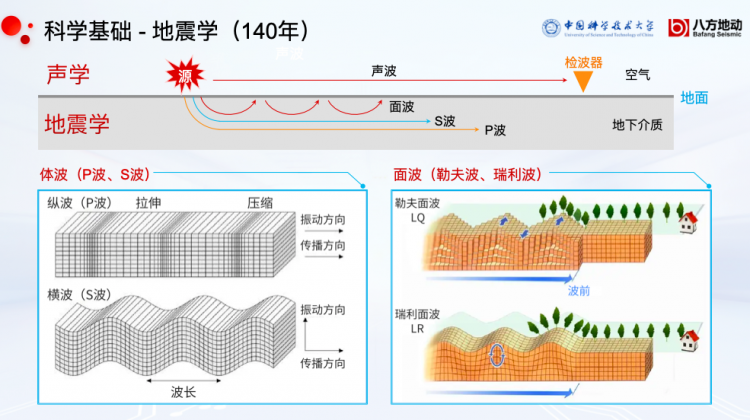

机器人非语音智能听觉,在居家、交通、公共场所、工作场所都有很多应用场景。在居家方面,它可以监测老人的身体健康与风险,可以预测电梯运行风险。在交通领域,它可以实现全程交通数字化,揭示每日道路下的构造变化,提示桥梁的振动发生变化。

以交通场景为例,现有的交通领域有摄像头、毫米波雷达等,但它面临的困境就是,安装视频雷达设施成本昂贵,摄像头便宜,但龙门架要求的质量非常高,要经得起八级大风、八级地震,成本动辄上百万,所以不能安装很多。当视觉覆盖不够,盲区就多;然而当视觉覆盖足够多,要是数据量太大,实施智能化又比较难。检测路下结构难以智能化;设备繁多,难以配套运行。这是中国目前智慧交通的痛点。

针对上述痛点,我们提出方案:采取智能听觉大模型,用地动仪进行5G传输、远程计算,就可以监测车流、车速、车重、路面、路下,还能监测行人、抛物、骤停、爆胎等行为。

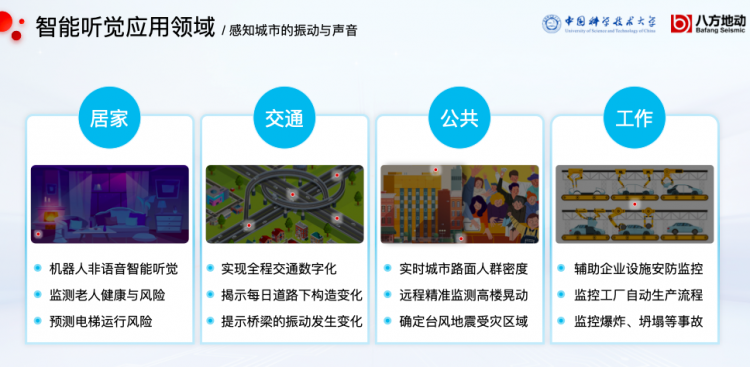

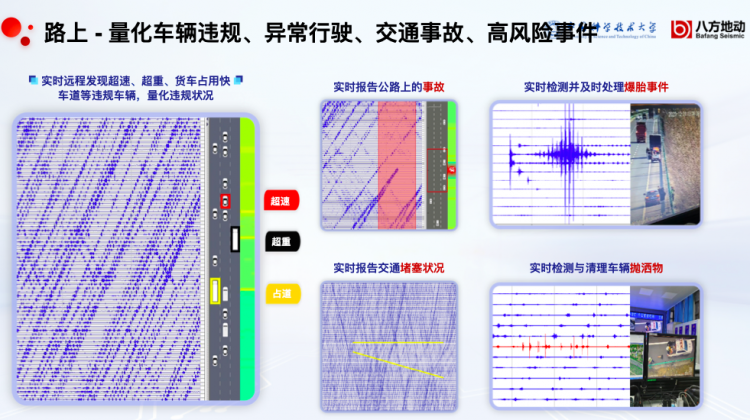

这是在合肥的一条高速公路上监测到的画面,左边的每一条线就是每一个车行进产生的振动数据,从线上我们可以解译出它行驶在第几车道,车型车速、异常驾驶行为,以及重量等信息。

交通领域进行数字化以后,我们通过振动就能够量化车辆违规、异常行驶、交通事故及高风险事件。右侧下图是交通部门在做实验,把安全锥往地下扔,模拟车辆抛洒物,记录这个行为所产生的振动。

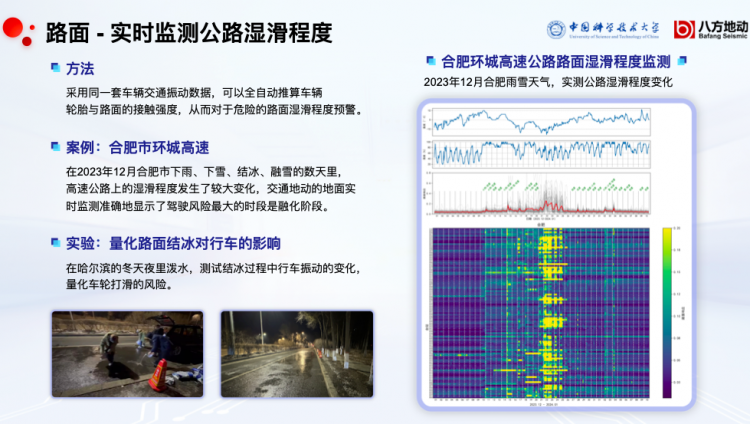

再从路面来看,在下雨结冰的路况下,轮胎和地面接触的声音发生了变化。这是2023年12月的交通实测结果,纵轴表示沿着公路布设的地动仪位置,横轴表示时间。一旦开始下雨打滑,画面就会出现黄色,冰雪融化的时候,画面出现的黄色比较多,意味着此时路面容易产生较大的轮胎打滑风险。大模型还能量化路面结冰对行车的影响。比如,我们在哈尔滨的冬夜里泼水,测试结冰过程中,行车振动的变化,量化车轮打滑的风险。

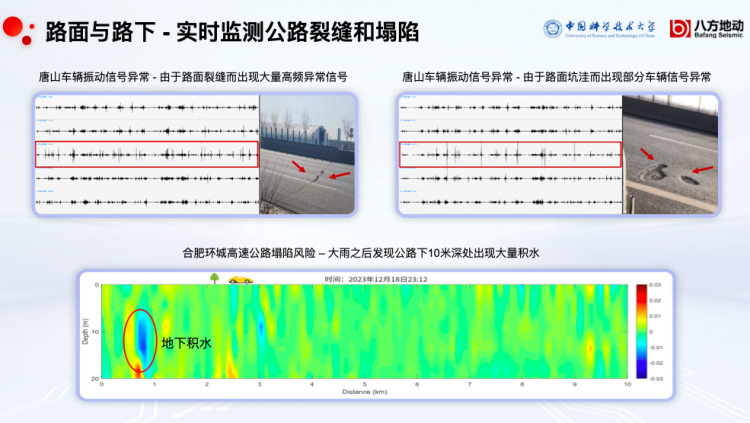

如果在开车行驶的路面前方,地面出现裂缝或者坑坑洼洼,那么在振动上就会接收到非常明显的信号。公路下面看不见的结构变化,也可以通过灵敏的地动仪进行监测。以车作为信号,地动仪可以用地球物理学的方法,实时反推地下结构的变化。

我们再看上图。合肥下了一场大雨之后,路下十米深的地方出现了地下积水,我们通过声音和振动就能听出来车的动静不一样,及时预测塌陷等情况,及时预报各种险情。

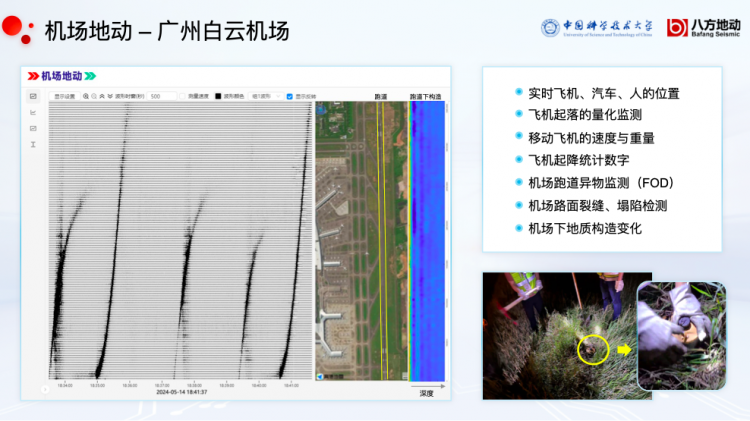

在广州白云机场,我们主要监测商用机场的飞机起飞和降落,这是全球商用机场第一次采用地动监测技术。有时,小飞机的降落相当于地震,大飞机的声音反而很小声,这取决于飞行员操纵飞机降落的水平,我们可以量化其中的参数。

同时,根据上图蓝颜色跑道下的构造,可以实时监测跑道下面发生什么结构变化,如果发现积水和塌陷风险,就可以提前预警。

视听结合,AI才能拥有完整的感知能力

研发与应用智能听觉的产业正在形成,我们在深圳创立的八方地动公司,也是全球第一家进入该领域的企业。

当前,智能视觉已经扩展至紫外线、X光等不可见光的领域,智能听觉也从语音扩展至非语音领域,甚至扩展到人类听不见的声音及振动的范围。

与其他大模型相比,智能听觉基于物理学,所以我们团队中物理学家很多。很多人说,既然你能做出“智能听觉”,那就不需要“智能视觉”了,其实不然。过去,人工智能只是凭着眼睛去做判断和识别,还没有“耳朵”去“听到”外在的声音,所以我们现在给机器人补充“耳朵”。

试想一下,一个人聋了不好,瞎了也不完整,所以,只有视觉和听觉相互协作、相互结合,人工智能才能拥有更高效率、更完整的感知能力。

目前,“非语音智能听觉”正成为一个全新的产业化赛道,在国内可应用于多个万亿市场,其应用场景已遍布交通、安防、新能源等各个领域,未来可期。

推荐阅读